Lo que oculta la inteligencia artificial Microsoft y las niñas vulnerables del norte de Argentina

Regiones

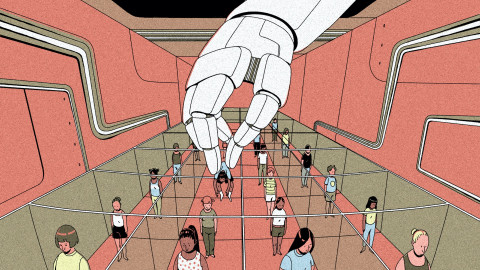

Bajo el ropaje de la neutralidad valorativa y el deslumbramiento que nos produce la novedad, la tecnología está consolidando la opresión de las naciones centrales sobre los países periféricos a través de grandes empresas que ocupan espacios en comunidades vulnerables

Illustration by Anđela Janković

En 1939 se estrenó la película El Mago de Oz. Uno de sus protagonistas estelares fue el perro adiestrado Terry (en el rol de Toto), que en el momento era considerado "el animal más inteligente del planeta". La cuestión de la inteligencia animal ocupó a buena parte de los pensadores de la época mientras en paralelo crecía el interés por entender si una máquina podía pensar, un claro desafío al sentido común del momento, que lo descartaba de plano, y que fue cuestionado de manera concreta 10 años después de que la cinta debutara en el cine por el trabajo del matemático británico Alan Turing.1 Durante gran parte del siglo XX, la idea de que los animales o las máquinas pudieran pensar era absolutamente descabellada ¡cuánto ha cambiado desde entonces!

A comienzos de 2016, El Mago de Oz fue el libro escogido por el gobernador de Salta, en Argentina, para distribuir entre estudiantes de su provincia que estaban aprendiendo a leer. Las niñas descubrieron en el texto firmado por L. Frank Baum que detrás de la magia siempre hay un hombre. Cuando pasaron a la adolescencia, ese aprendizaje se extendió a otros órdenes más concretos de sus vidas: que no hay magia, sino hombres, detrás de la pobreza, de las promesas, de los desengaños y de los embarazos.

En ese entonces la inteligencia artificial había dejado de ser el desafío de Turing para convertirse en el área de conocimiento favorita de las empresas más poderosas e influyentes del mundo y, gracias a aplicaciones atractivas en dispositivos personales como teléfonos celulares y plataformas de streaming, logró popularizarse entre muchas personas.

Hasta hace unos pocos años solo escuchábamos la frase “inteligencia artificial” para hacer referencia a HAL 90002 de 2001. Odisea del espacio o al androide Data de Star Trek, pero hoy pocos se sorprenden de su uso cotidiano. El consenso en los medios de comunicación y en cierta bibliografía académica es que nos encontramos frente a una de las revoluciones tecnológicas más importantes de la historia.

Sin embargo, el deslumbramiento que esta tecnología –que parece salida de un cuento de hadas o de una película de ciencia ficción– genera, esconde su verdadera naturaleza: se trata de una creación tan humana como los mecanismos que el supuesto mago de Oz quería hacer pasar como eventos divinos y sobrenaturales. En manos del aparato estatal y de grandes corporaciones, la inteligencia artificial puede ser un instrumento eficaz de control, vigilancia, dominación y consolidación del statu quo, tal como quedó de manifiesto cuando el gigantesco Microsoft se alió al gobierno de Salta con la promesa de que un algoritmo podría ser la solución a la crisis de deserción escolar y embarazo adolescente de aquella región argentina.

Esparta Palma/CC BY 2.0 via Wikimedia Commons

Algoritmos que predicen embarazos adolescentes

Un año después de que entregara copias de El mago de Oz a las escuelas de su provincia, el gobernador de Salta, Juan Manuel Urtubey, anunció un convenio con la filial nacional de Microsoft para la aplicación de una plataforma de inteligencia artificial destinada a la prevención de lo que calificó como “uno de los problemas más urgentes” de la región. Se estaba refiriendo al alza en el número de embarazos adolescentes. Según las estadísticas oficiales, en 2017, más del 18 % de los partos totales de la provincia fueron de gestantes menores de diecinueve años: 4.914 hijos e hijas, a razón de más de trece por día.

En la promoción de su iniciativa, el gobernador manifestó: “Lanzamos un programa para prevenir el embarazo adolescente utilizando inteligencia artificial de la mano de una reconocidísima empresa de software del mundo. Con la tecnología vos podés prever cinco o seis años antes, con nombre, apellido y domicilio, cuál es la niña, futura adolescente, que está en un 86 % predestinada a tener un embarazo adolescente” (Página 12, 2018).

Casi con la misma fanfarria con la que el mago de Oz recibía a los visitantes que lograban recorrer el camino empedrado de ladrillos dorados, Microsoft daba el anuncio del acuerdo como una “iniciativa innovadora, única en el país y un gran paso en el proceso de transformación digital de la provincia”.3

La alianza entre la gigante tecnológica y el gobierno tenía un tercer actor, la Fundación CONIN, presidida por Abel Albino, médico activista en contra de la legalización del aborto y del uso de preservativos (Perfil, 2018).

Es esta alianza la que explica los intereses políticos, económicos y culturales detrás de este programa: una consolidación de la noción de familia en la que el sexo y los cuerpos de las mujeres están al servicio de la reproducción, supuestos fines últimos y sagrados que deben ser protegidos a toda costa. Es una visión conservadora conocida desde hace siglos en América Latina, pero que aquí se viste de ropajes vistosos gracias a la complicidad de una compañía de capitales estadounidenses como Microsoft y la utilización de términos como inteligencia artificial que, como explicaremos en la siguiente sección, parece ser suficiente para garantizar eficacia y modernidad.

En esos anuncios, se informó, además, parte de la metodología de trabajo. Por ejemplo, se comunicó que la información de base “es entregada voluntariamente por las personas” y permite “trabajar en la prevención del embarazo adolescente y la deserción escolar. Los algoritmos inteligentes permiten identificar características en las personas que podrían derivar en alguno de estos problemas y advierten al gobierno”. El Coordinador de Tecnología del Ministerio de Primera Infancia de Salta, Pablo Abeleira, declaró que “a nivel tecnológico, el modelo que desarrollamos tiene un nivel de precisión de casi un 90% de una prueba piloto realizada en Salta capital” (Alonso, 2018).

Pero ¿qué se escondía detrás de los artificios?

El mito de una inteligencia artificial objetiva y neutral

Aunque ya está instalada no solo en el discurso público sino también en nuestra vida cotidiana, en ocasiones nos parece que todas las personas saben a qué nos referimos cuando hablamos de inteligencia artificial (IA). Sin embargo, el término está lejos de ser unívoco. No solo porque suele ser utilizada como una noción paraguas bajo la que aparecen conceptos vinculados y muy cercanos pero que no son sinónimos, como aprendizaje automatizado (machine learning), aprendizaje profundo (deep learning) o computación cognitiva, entre otros. Sino porque un análisis más pormenorizado revela que la misma noción de inteligencia en este contexto es polémica.

En este texto, usaremos IA para hacer referencia a sistemas o modelos de algoritmos que pueden procesar grandes volúmenes de información y datos a la vez que pueden aprender y mejorar en su tarea más allá de cómo fueron programados originalmente. Por ejemplo, es un caso de IA un algoritmo que, luego de procesar cientos de miles de fotos de gatos, puede extraer lo que necesita para poder reconocer a un gato en una nueva imagen, sin confundirlo con un juguete o un almohadón. A medida que se le entregan más y más fotografías, en general más aprenderá y menos errores cometerá.

Estos desarrollos de IA se están dando en todo el mundo y ya están presentes en tecnologías cotidianas como el reconocimiento de voz de asistentes virtuales como Siri y Alexa o en proyectos más ambiciosos como automóviles que no necesitan conductor o estudios para poder detectar de manera temprana enfermedades como el cáncer. El campo de aplicación de estos desarrollos es vastísimo y afecta a muchas industrias y sectores de la sociedad, como la economía, con el auge de algoritmos que prometen sugerir las mejores inversiones en la bolsa de valores; la política, con campañas en redes sociales a favor o en contra de un candidato creadas para interpelar a distintos individuos en particular a partir de sus preferencias y conductas en la web, o en la cultura, con recomendaciones personalizadas en plataformas de streaming de series, películas o música.

El suceso de estas aplicaciones de la tecnología y las promesas de beneficios que hasta hace algunos años sólo existían en la ciencia ficción consiguieron sobredimensionar la percepción de lo que realmente puede hacer la IA. Hoy es considerada en vastísimos espacios como el punto máximo de la actividad racional, libre de prejuicios, pasiones y cualquier error humano.

Sin embargo, esto no es más que un mito. No existe algo tal como una IA objetiva o libre de valores humanos. Es inexorable el impacto de nuestra condición humana –quizás demasiado humana– sobre la tecnología.

Una manera de dejar en claro esto es quitar ciertos velos tras los que se esconde un término como algoritmo. Desde la filosofía de la tecnología, podemos distinguir entre al menos dos modos de caracterizarlo conceptualmente. En sentido estrecho, un algoritmo es un constructo matemático que se selecciona dada su eficacia pasada en la resolución de tareas similares a las que plantea el problema que ahora se pretende resolver (como las redes neuronales profundas, las redes bayesianas o las cadenas de Markov). 4 En sentido amplio, por su parte, un algoritmo es un sistema tecnológico que comprende varios insumos como los datos de entrenamiento, que producen un modelo estadístico diseñado, ensamblado e implementado para resolver un problema práctico formulado previamente.

Todo comienza con la concepción ingenua en torno a los datos. Estos surgen de un proceso de selección y abstracción y, en consecuencia, no son nunca una descripción objetiva del mundo, sino que son inexorablemente parciales y sesgados en la medida en que resultan de decisiones y elecciones humanas. Así, por ejemplo, se decide incluir ciertos atributos y dejar de lado otros.

Lo mismo sucede con la noción misma de predicción que surge de los datos, ya que una cuestión clave para el uso gubernamental de la ciencia de datos en general y del aprendizaje automatizado en particular estriba en decidir qué medir y cómo medirlo a partir de una definición del problema que se pretende abordar, lo que lleva a elegir el algoritmo, en sentido estrecho, que se evalúa como más eficiente para esa tarea, sin perjuicio de que pueda tener consecuencias letales (Brunet, Font y Rodríguez, 2022). Por consiguiente, la gravitación humana es crucial para establecer qué problema se quiere solucionar.

Así, queda claro que hay un vínculo inextricable entre la IA y una secuencia de decisiones humanas. Allí donde el aprendizaje automatizado nos provee las ventajas del rápido procesamiento de una voluminosa cantidad de datos y la capacidad de extraer patrones a partir de ellos, hay una serie de instancias donde la supervisión humana no solo es posible, sino necesaria.

Desnudando a la IA

Cuando Dorothy, el Hombre de Hojalata, el León y el Espantapájaros logran conocer al mago de Oz quedan fascinados por la voz grave y sobrenatural de este ser, que en la versión fílmica de 1939 tiene el timbre de Frank Morgan y se presenta como un altar de fuego y humo místico. Sin embargo, Toto, el perro de la niña, no parece quedar tan impresionado y muerde una cortina hasta dejar al descubierto el engaño: hay alguien al mando de una serie de palancas y botones conduciendo todo lo que sucede en el escenario. Muerto de miedo y vergüenza, el supuesto mago intenta mantener la farsa: "No le presten atención al hombre detrás del telón". Pero, acorralado por los protagonistas, debe confesar su engaño: “Solo soy un hombre normal”, le confiesa a Dorothy y a sus amigos. El Espantapájaros, sin embargo, lo corrige al instante: “Eres más que eso: ¡eres una estafa!”.

Cuando le quitamos los ropajes y vestidos lujosos a la IA la podremos ver tal y como realmente es: un producto del accionar humano que, por lo tanto, lleva en su seno las marcas de sus creadores. En ocasiones, incluso, se la considera como similar en sus procesos al pensar humano pero carente de errores o prejuicios. Así, frente a la extendida y persuasiva retórica acerca de su neutralidad valorativa y la objetividad que le sería concomitante, debemos analizar la ineludible gravitación de intereses humanos calificados en diferentes etapas de esta supuesta tecnología mágica.

La promesa que Microsoft y el gobierno salteño de poder predecir “cinco o seis años antes, con nombre, apellido y domicilio, cuál es la niña, futura adolescente, que está en un 86 % predestinada a tener un embarazo adolescente” terminó siendo solo una promesa incumplida.

Y el fiasco comenzó con los datos: se utilizaron bases reunidas por el gobierno provincial y organizaciones de la sociedad civil en barrios de bajos ingresos de Salta capital durante 2016 y 2017. La encuesta llegó a poco menos de 300 mil personas, de las cuales 12.692 eran niñas y adolescentes entre 10 y 19 años. En el caso de las menores de edad, la información fue recogida luego de obtener el consentimiento de “los jefes de hogar” (sic).

Estos datos nutrieron un modelo de aprendizaje automático que, según sus implementadores, permite predecir, con un grado cada vez mayor de precisión, qué niñas y adolescentes cursarán un embarazo en el futuro. Se trata de un absoluto absurdo: Microsoft estaba vendiendo un sistema que prometía algo técnicamente imposible (Eubanks, 2018). Esto es, se obtiene un listado de personas a las cuales les fue asignada una probabilidad de embarazo. Los algoritmos, lejos de autoejecutar políticas, brindaban la información al Ministerio de Primera Infancia para que abordara los casos identificados.

No se precisó desde el Estado salteño en qué consistiría ese abordaje, ni los protocolos empleados, ni las acciones de seguimiento previstas, ni el impacto de las medidas aplicadas –ni si ese impacto se ha medido de algún modo–, ni los criterios de selección de los organismos no gubernamentales o fundaciones involucrados, ni el rol de la iglesia.

El proyecto también tuvo fallas técnicas graves: según una investigación de la World Web Foundation (Ortiz Freuler e Iglesias, 2018), no existe información accesible sobre las bases de datos empleadas, ni sobre la hipótesis que sirve de apoyo para el diseño de los modelos, ni sobre el proceso de diseño de los modelos finales, criticando la opacidad del proceso. Además, se ha sostenido que la iniciativa omite evaluar cuáles son las inequidades que se pueden producir y prestar especial atención a los grupos minoritarios o vulnerables que pueden verse afectados, amén de las dificultades de trabajar con un rango de edad tan amplio en los relevamientos y el riesgo de discriminación o aun criminalización inherente al sistema.

Los especialistas coincidieron en que hubo una contaminación sutil de los datos de evaluación ya que los datos sobre los cuales se evalúa el sistema no son distintos de los datos que se usan para entrenarlo. Por otra parte, los datos son inadecuados para el fin que se persigue. Estos datos provinieron de una encuesta a adolescentes que residían en la provincia de Salta, que indagaba información sobre su persona (edad, etnia, país de origen, etc.), su entorno (si contaba con agua caliente en su vivienda, con cuántas personas cohabitaba, etc.) y sobre si había cursado o estaba cursando un embarazo. Ahora bien, la pregunta que se intentaba responder a partir de estos datos actuales era si una adolescente podía cursar un embarazo en el futuro, algo que, más que una predicción, tiene el aspecto de una premonición. Eran, además, informaciones sesgadas porque los datos sobre embarazos adolescentes, por la sensibilidad inherente a esta clase de temas, tienden a estar incompletos o, directamente, ocultos.

Los investigadores del Laboratorio de Inteligencia Artificial Aplicada del Instituto de Ciencias de la Computación de la Universidad de Buenos Aires determinaron que, además de utilizar estos datos poco confiables, la iniciativa de Microsoft adolece de desaciertos metodológicos serios. Además, plantean el riesgo de tomar medidas incorrectas a los responsables de políticas públicas: “Las técnicas de inteligencia artificial son poderosas y demandan responsabilidad por parte de quienes las emplean; son solo una herramienta más, que debe complementarse con otras, y de ningún modo reemplazan el conocimiento o la inteligencia de un experto”, especialmente en un área tan sensible como la salud pública y los sectores vulnerables.5

Y es que este es uno de los nudos conflictivos graves: aun si fuera posible (lo cual no parece ser el caso) predecir el embarazo adolescente, no queda claro para qué se haría: la prevención permanece ausente en todo el proceso. Considerar un riesgo alto de estigmatización de niñas y adolescentes por esta causa es, entonces, inevitable.

Coolcaesar/CC BY-SA 4.0 via Wikimedia Commons

La IA como herramienta del poder contra las poblaciones vulnerables

Desde el inicio, la alianza entre Microsoft, el gobierno salteño y la Fundación CONIN se fundó en preconceptos que no solo son cuestionables sino que se enfrentan a principios y normas amparadas por la Constitución argentina y las convenciones internacionales incorporadas al sistema nacional. Así, se parte, de manera incontestable, de la idea de que el embarazo (infantil y adolescente) es una catástrofe que, en ciertos casos, sucederá indefectiblemente si no se interviene de manera directa para evitarla. Esta premisa apareja, de manera correlativa, una postura muy difusa respecto de la atribución de responsabilidades.

Por un lado, quienes planearon y desarrollaron el sistema parecen ver al embarazo como un suceso que se da sin responsabilidad de nadie. Por otro, colocan su responsabilidad en las niñas o adolescentes embarazadas. Esta anfibología, en una u otra de sus alternativas, conduce en primer lugar a la objetivación de las personas involucradas y a la invisibilización de los responsables; para empezar, los hombres (o adolescentes, o niños, pero principalmente hombres) que contribuyeron de manera necesaria al embarazo (suele afirmarse, con un burdo giro eufemístico, que la niña o adolescente “se embarazó”). Pero, en segundo término, también soslaya que, en gran parte de los casos de embarazo de jóvenes, y en todos los de niñas, el consentimiento de la persona gestante no solo no puede presuponerse, sino que debe descartarse. Dicho en pocas palabras, esta posición oculta un aspecto del fenómeno que no podría ser más relevante: todos los embarazos de niñas y muchos de los de jóvenes son el producto de una violación.

En otro plano, y ya reparando en el aspecto menos atendido del sistema, esto es, la predicción de la deserción escolar, se presupone (y se concluye en) que un embarazo de una estudiante apareja de manera inexorable el abandono de la escolaridad. Si bien no puede ignorarse que, de hecho, el embarazo y la maternidad tempranas importan un costo de oportunidad para las mujeres, lo cierto es que la interrupción o el abandono de la trayectoria educativa no es una consecuencia inevitable, y existen programas y políticas inclusivas que han demostrado ser exitosos para contribuir a su evitación o su merma.

Desde una visión más general, el sistema y sus aplicaciones afectan derechos que forman parte del espectro de los derechos sexuales, considerados como derechos humanos. La sexualidad es un aspecto nuclear en el desarrollo de las personas, con independencia de si deciden o no reproducirse. Cuando se trata de menores de edad, han de marcarse diferencias de acuerdo con sus capacidades evolutivas, aunque siempre teniendo en cuenta que la orientación de las niñas y los niños por parte de los padres u otras personas responsables deben priorizar sus capacidades para ejercer derechos en su propio nombre y beneficio. En lo que hace a los derechos sexuales en particular, esas consideraciones son específicas. Por ejemplo, deben respetarse las circunstancias particulares de cada niña, niño o adolescente, su nivel de comprensión y madurez, su salud física y mental, el vínculo con sus familiares y, eventualmente, la situación concreta que le toca enfrentar.

Este uso de la IA afecta de manera concreta derechos de las niñas o jóvenes (también potenciales) gestantes. En primer término, hay una afectación del derecho a la autonomía personal de las niñas y jóvenes que fueron materia prima del proyecto. Ya se hizo mención a su objetivación, al trato indiferente respecto de sus intereses particulares en pos de un supuesto interés general. Las niñas y adolescentes no son si quiera consideradas sujetos de derecho y sus deseos y preferencias personales son desconocidos por el Estado.

En este proyecto de Microsoft la IA fue utilizada como una herramienta de poder contra niñas y jóvenes, que fueron catalogadas sin su consentimiento (ni, aparentemente, su conocimiento). Las consultas pertinentes fueron evacuadas, según los promotores del sistema, por los jefes de familia (en especial, sus padres), sin siquiera invitarlas a participar. Y, además, los cuestionarios tratan sobre cuestiones personalísimas (su intimidad, su vida sexual, etc.) sobre cuyos detalles sus padres, por lo habitual, no estarían en condiciones de responder sin invadir su esfera de privacidad o –algo que parece también muy grave– basarse en suposiciones o en prejuicios que el Estado asumirá como verdaderos y legítimos.

También se vulneraron otros derechos, como el de intimidad, privacidad y libertad de expresión u opinión mientras que los derechos a la salud y educación corren riesgo de ser desconocidos, a pesar de las manifestaciones de las autoridades y de la multinacional respecto de su intención de cuidar a las niñas y adolescentes. Finalmente, merece mención un derecho conexo que, en el contexto especial del proyecto, cobra una relevancia singular: el derecho a la libertad de pensamiento, de conciencia y de religión.

No nos animamos a sugerir que el episodio tuvo, como en El Mago de Oz, un final feliz. Pero sí que el proyecto de Microsoft no duró mucho. Aunque su interrupción no aconteció por las críticas de los activismos sino por un motivo mucho más mundano: en 2019 se desarrollaron elecciones nacionales en la Argentina y Urtubey no logró ser reelegido. La nueva gestión descontinuó varios programas, incluyendo el de uso de algoritmos para predecir embarazos, y degradó al Ministerio de Primera Infancia, Niñez y Familia al rango de secretaría.

Lo que oculta la IA

Los efectos de humo y luces de la retórica de los desarrollos de inteligencia artificial valorativamente neutrales y objetivos parecen desmoronarse cuando se enfrenta a aquellas voces que aseguran mostrar su imposibilidad por principio, tal como señalamos en la primera sección, como cuando se exhibe la participación de analistas humanos en numerosas etapas del desarrollo de los algoritmos. Son hombres y mujeres quienes determinan el problema al que hay que dar respuesta, quienes los diseñan y preparan los datos, seleccionan qué algoritmos de aprendizaje automático son los más apropiados, interpretan críticamente los resultados del análisis y planifican la acción adecuada a tomar en función de las ideas que el análisis ha revelado.

El avance de esta tecnología no está acompañado por una suficiente reflexión y discusión abierta acerca de sus consecuencias no deseadas. Parece prevalecer en la sociedad la noción de que la aplicación de algoritmos en diferentes ámbitos no sólo es garantía de eficiencia y rapidez sino también de la no intervención de los prejuicios humanos, que pueden ensuciar el prístino accionar de los códigos que son el núcleo de los algoritmos. Así, se da por sentado que la IA fue creada para mejorar a la sociedad en su conjunto o, con más modestia, a ciertos procesos y productos. Sin embargo, no solo no se problematiza lo más elemental, esto es: para quién representaría esto una mejora, quién se beneficiaría, quién evalúa la mejora –¿los ciudadanos?, ¿el Estado?, ¿las empresas?, ¿las adolescentes salteñas?, ¿los adultos que abusaron de ellas?– sino que no parece haber una real conciencia de la dimensión de su impacto social o de la necesidad de discutir si tal cambio es evitable.

Las continuas novedades sobre la inserción de la IA en nuevos ámbitos son recibidas como un dato que no sorprende más que por lo novedoso, y que, inexorable como el avance del propio tiempo, no puede ser impedido o revisado. La creciente automatización de procesos que antes eran realizados por humanos puede generar alarma y desazón, pero no el interés por tratar de detenerlo o preguntarse cuál es el futuro del trabajo o el de las personas una vez que la IA se haga cargo de nuestras tareas laborales. Se impone una serie de preguntas que raramente se formulan: ¿es eso algo deseable?, ¿para qué sector de la sociedad?, ¿quién se beneficiará de esta transformación y quién saldrá perdiendo?, ¿qué podemos esperar de un futuro en el que gran parte de las ocupaciones tradicionales serán llevadas adelante por máquinas? No parece haber tiempo ni espacios para discutir sobre eso: la automatización simplemente ocurre y solo nos resta quejarnos por el mundo perdido o maravillarnos por lo que es posible lograr hoy.

Esta pasividad frente al continuo avance de la tecnología en nuestra vida privada, pública, laboral y cívica parece posible gracias a la confianza generada por la creencia de que estos desarrollos son superiores a lo que se podría conseguir a través del mero esfuerzo humano. De acuerdo con esto, ya que la IA es mucho más poderosa, es inteligente (la etiqueta smart hoy se aplica a teléfonos celulares, aspiradoras y cafeteras, entre otros objetos que harían sonrojar a Turing) y está libre de sesgos e intencionalidades. Sin embargo, como hemos señalado, es imposible por principio plantear una IA valorativamente neutra. Dicho en pocas palabras y de manera clara: los sesgos están presentes en todas las etapas del diseño, las pruebas y la aplicación de los algoritmos y, por eso mismo, son muy difíciles de identificar y más arduos aún de corregir. Sin embargo, es una tarea necesaria para desenmascarar su supuesto carácter aséptico, carente de los valores y errores humanos.

Un enfoque centrado en los peligros de la IA, junto con el optimismo sobre su potencial, puede conducir a una dependencia excesiva de la IA como una solución a nuestras preocupaciones éticas, a un enfoque en que la IA deba responder a los problemas generados por la IA. Si los problemas se consideran únicamente tecnológicos, deberían requieren únicamente soluciones tecnológicas. En cambio, tenemos decisiones humanas disfrazadas de decisiones tecnológicas. Necesitamos un enfoque diferente.

El caso de algoritmos que predicen embarazos adolescentes en Salta deja al descubierto la inviabilidad de la imagen de pretendida objetividad y neutralidad de la inteligencia artificial. Al igual que Toto, no podemos dejar de ver al hombre detrás del telón: el desarrollo de algoritmos no es neutral, sino que se realiza a partir de una decisión en medio de muchas posibles elecciones. En este sentido, como el diseño y la funcionalidad de un algoritmo reflejan los valores de sus diseñadores y de sus usos pretendidos, los algoritmos inexorablemente conducen a decisiones sesgadas. Hay decisiones humanas en la definición del problema, el diseño y la preparación de datos, la selección del tipo de algoritmo, la interpretación de los resultados y la planificación de acciones a partir de su análisis. Sin una supervisión humana calificada y activa, ningún proyecto de algoritmo de inteligencia artificial podrá lograr sus objetivos y ser exitoso. Los mejores resultados de la ciencia de datos se producen cuando la experiencia humana y la potencia de los algoritmos trabajan de forma conjunta.

Los algoritmos de inteligencia artificial no son mágicos, pero tampoco tienen que ser, como sostenía el Espantapájaros, una estafa. Basta con reconocer que son humanos.

Bibliografía

Alonso, Alejandro (28 de marzo de 2018). Microsoft democratiza la IA y los servicios cognitivos. It.sitio. https://www.itsitio.com/es/microsoft-democratiza-la-ia-y-los-servicios-…

Brunet, Pere, Font, Tica y Rodríguez, Joaquín (2022). Robots asesinos: 18 preguntas y respuestas. https:// centredelas.org/publicacions/robots-asesinos-18-preguntas-y-respuestas/?lang=

Eubanks, Virginia (2018). Automating Inequality; How high-tech tools profile, police and punish the poor. Nueva York: St Martin’s Press.

Laboratorio de Inteligencia Artificial Aplicada (2018). Sobre la predicción automática de embarazos adolescentes. https://liaa.dc.uba.ar/es/sobre-la-prediccion-automatica-de-embarazos-a…

Microsoft News Center LATAM (2017). Microsoft y el gobierno de Salta firman un acuerdo para aplicar la inteligencia artificial en la prevención de los problemas más urgentes. https://news.microsoft.com/ es-xl/microsoft-gobierno-salta-firman-acuerdo-aplicar-la-inteligencia-artificial-la-prevencion-los-problemas-masurgentes/

Ortiz Freuler, Juan e Iglesias, Carlos (2018). Algoritmos e Inteligencia Artificial en Latinoamérica: Un Estudio de implementaciones por parte de Gobiernos en Argentina y Uruguay. World Wide Web Foundation. https://webfoundation.org/docs/2018/09/WF_AI-in-LA_Report_Spanish_Scree…

Página 12 (2018). La inteligencia artificial de Urtubey. https://www.pagina12.com.ar/107412-lainteligencia-artificial-de-urtube

Perfil (2018). Albino dijo que el preservativo no protege porque “el virus del SIDA atraviesa la porcelana” https://www.perfil.com/noticias/politica/albino-dijo-que-el-preservativ…

Wikipedia, la enciclopedia libre (2023). https://es.wikipedia.org/wiki/Alan_Turing

Wikipedia, la enciclopedia libre (2023). https://es.wikipedia.org/wiki/HAL_9000